Apple ha recentemente presentato due strumenti AI: MGIE (MLLM-Guided Image Editing) e Keyframer. Queste tecnologie all’avanguardia promettono di ridefinire il modo in cui gli utenti interagiscono con immagini e animazioni, sfruttando la potenza dell’intelligenza artificiale per semplificare compiti complessi e rendere gli sforzi creativi più accessibili a tutti.

MGIE di Apple ti consente di modificare le foto con comandi in linguaggio naturale, Keyframer anima l'arte con istruzioni di testo

In collaborazione con i ricercatori dell’Università della California, Santa Barbara, Apple ha introdotto MGIE, un modello di intelligenza artificiale progettato per rivoluzionare l’editing delle immagini attraverso comandi in linguaggio naturale. Sfruttando modelli multimodali di linguaggio di grandi dimensioni (MLLM), MGIE interpreta le istruzioni dell'utente per eseguire manipolazioni precise a livello di pixel, offrendo un'esperienza di editing fluida e intuitiva. Dalle regolazioni di base come il ritaglio e il ridimensionamento alle modifiche avanzate come la manipolazione degli oggetti e il miglioramento del colore, MGIE consente agli utenti di liberare la propria creatività senza la necessità di software specializzato.

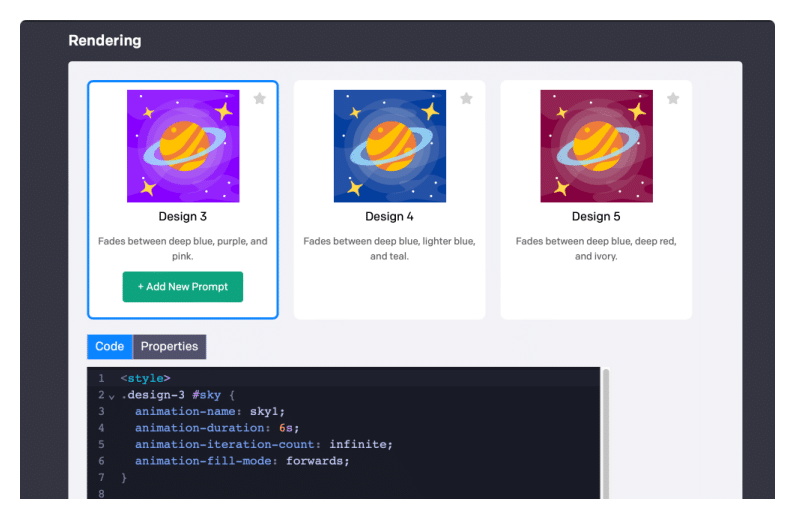

Keyframer di Apple rappresenta un progresso significativo nella progettazione delle animazioni, consentendo agli utenti di animare immagini statiche utilizzando semplici istruzioni di testo. Basato su modelli linguistici di grandi dimensioni (LLM), Keyframer genera codice di animazione CSS da immagini SVG statiche e descrizioni testuali, eliminando la necessità di software di animazione complessi. Sebbene sia ancora nella fase di prototipo, Keyframer racchiude un immenso potenziale per la futura integrazione nell’ecosistema di prodotti Apple, aprendo la strada alla creazione di animazioni intuitive e accessibili. Da un fogliopubblicatodai ricercatori Apple:

Keyframer è uno strumento di prototipazione di animazioni basato su LLM (Large Language Model) in grado di generare animazioni da immagini statiche (SVG). Gli utenti possono ripetere la progettazione aggiungendo prompt e modificando il codice o le proprietà dell'animazione CSS generati da LLM. Inoltre, gli utenti possono richiedere varianti di progettazione per supportare la loro ideazione ed esplorazione.

Sebbene le interfacce di prompt one-shot siano comuni nei sistemi commerciali text-to-image come Dall·E e Midjourney, sosteniamo che le animazioni richiedono un insieme più complesso di considerazioni da parte dell'utente, come tempistica e coordinazione, che sono difficili da specificare completamente in un singolo prompt; quindi, approcci alternativi che consentono agli utenti di costruire e perfezionare in modo iterativo i progetti generati potrebbero essere necessari soprattutto per le animazioni.

Lettura consigliata:iMessage in iOS 18 per offrire animazioni, RCS e AI

Abbiamo combinato i principi di progettazione emergenti per la guida basata sul linguaggio degli artefatti di progettazione con le capacità di generazione di codice degli LLM per creare un nuovo strumento di animazione basato sull'intelligenza artificiale chiamato Keyframer. Con Keyframer, gli utenti possono creare illustrazioni animate da immagini 2D statiche tramite suggerimenti in linguaggio naturale. Utilizzando GPT-4 3, Keyframer genera codice di animazione CSS per animare un input Scalable Vector Graphic (SVG).

Sia MGIE che Keyframer esemplificano la richiesta di potenziare la creatività e democratizzare il design. Sfruttando l’intelligenza artificiale e l’elaborazione del linguaggio naturale, questi strumenti abbattono le barriere all’ingresso, rendendo accessibili funzionalità avanzate di editing e animazione a utenti di tutti i livelli di competenza.

Per saperne di più:

- Apple svelerà le funzionalità di intelligenza artificiale generativa per Siri alla WWDC 2024 – Gurman — Classic e